| Grundlagen der Statistik enthält Materialien verschiedener Vorlesungen und Kurse von H. Lohninger zur Statistik, Datenanalyse und Chemometrie .....mehr dazu. |

|

Home  Multivariate Daten Multivariate Daten  Modellbildung Modellbildung  Neuronale Netze Neuronale Netze  Multilayer Perceptron Multilayer Perceptron  Backpropagation Backpropagation |

|

| Siehe auch: Mehrschichtiges Perzeptron | |

| Search the VIAS Library | Index | |

|

ANN - BackpropagationAuthor: Hans Lohninger

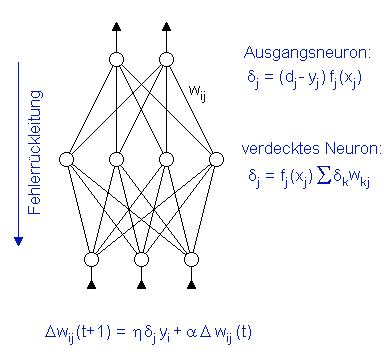

Der erste Trainingsalgorithmus, der - historisch gesprochen - fähig war, mit verdeckten Schichten in neuronalen Netzwerken umzugehen, heißt "backpropagation of errors" (Fehlerrückleitung). Er wird zur Anpassung der Gewichte in einem mehrschichtigen Perzeptron (engl. multi-layer perceptron) verwendet, das eine Eingangsschicht, eine oder mehrere verdeckte Schichten und eine Ausgangsschicht hat. Mehrschichtige Perzeptrons werden oft auch als "Backpropagation-Netzwerke" bezeichnet, was den enormen Einfluss verdeutlicht, den dieser Algorithmus auf die Entwicklung künstlicher neuronaler Netzwerke hatte. Die Grundprinzipien des Backpropagation-Algorithmus sind:

Während des Trainings werden die Daten dem Netzwerk einige tausend Male präsentiert. Für jede Datenprobe wird das Ausgangssignal des Netzwerks berechnet und dann mit dem "wahren" Sollwert verglichen. Das Fehlersignal δj des Neurons j wird von der Differenz zwischen dem Soll- und dem berechneten Ausgabewert berechnet. Für verdeckte Neuronen wird diese Differenz über die gewichteten Fehlersignale der darüber liegenden Schicht berechnet. Die Fehler werden dann verwendet, um die Gewichte wij des neuronalen Netzwerks abzustimmen.

Das Netzwerk stellt seine Gewichte nach jedem präsentierten Datensatz neu ein. Dieser Lernprozess entspricht eigentlich einem Gradientenabstieg in der Fehlerfläche des Gewichteraums - mit all seinen Nachteilen. Der Lernalgorithmus ist langsam und neigt dazu, in lokalen Minima stecken zu bleiben. Für den Backpropagation-Algorithmus müssen die Anfangsgewichte der Neuronen relativ klein sein. Sie können zum Beispiel zufällig aus einem kleinen Intervall um null gewählt werden. Während des Trainings werden sie dann langsam angeglichen. Mit kleinen Gewichten zu starten ist entscheidend, weil große Gewichte unbeweglich sind und nicht schnell genug geändert werden können. Das folgende interaktive Beispiel zeigt, wie ein mehrschichtiges Perzeptron lernt, Daten zu modellieren.

|

|

Home  Multivariate Daten Multivariate Daten  Modellbildung Modellbildung  Neuronale Netze Neuronale Netze  Multilayer Perceptron Multilayer Perceptron  Backpropagation Backpropagation |

|

Last Update: 2021-08-15